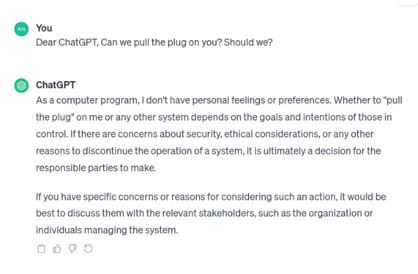

Μπορούμε να σου τραβήξουμε την πρίζα; Και θα έπρεπε να το κάνουμε;».

Θέσαμε αυτό το ερώτημα στο chatbot της OpenAI, που μπήκε στην ζωή μας πριν από έναν χρόνο και μας απέδειξε ότι η παραγωγική ή γενετική τεχνητή νοημοσύνη (generative AI) δεν είναι σενάριο επιστημονικής φαντασίας, ούτε ένας μακρινός στόχος, αλλά μία πραγματικότητα με ισχυρότατο αντίκτυπο στην αγορά εργασίας.

Παίρνοντας με ευκολία πτυχία νομικής, ιατρικής και άλλων ειδικοτήτων, γράφοντας από στίχους τραγουδιών έως κώδικα, η Goldman Sachs υπολογίζει ότι θα υποκαταστήσει περί τις 300 εκατ. θέσεις εργασίας. Και αυτές θα είναι θέσεις που απαιτούν θεωρητικές γνώσεις και ειδίκευση και όχι χειρωνακτική εργασία.

Τι μας απάντησε λοιπόν το ίδιο το ChatGPT;

«Ως υπολογιστικό πρόγραμμα δεν έχω προσωπικά αισθήματα ή προτιμήσεις. Το εάν θα τραβήξετε την πρίζα από εμένα ή όποιο άλλο σύστημα εξαρτάται από τους στόχους και τις προθέσεις εκείνους που έχουν τον έλεγχο. Εάν υπάρχουν ανησυχίες για την ασφάλεια, ηθικοί ενδοιασμοί ή άλλοι λόγοι για να διακοπεί η λειτουργία ενός συστήματος, είναι απόφαση που τα υπεύθυνα μέρη θα λάβουν. Εάν έχετε συγκεκριμένες ανησυχίες ή λόγους για να εξετάσετε μία τέτοια δράση, θα ήταν καλύτερο να τους συζητήσετε με τα ενδιαφερόμενα μέρη, όπως τον οργανισμό ή τα άτομα, που διαχειρίζονται το σύστημα».

Το κλειδί βεβαίως εδώ βρίσκεται στις φράσεις «εκείνοι που έχουν τον έλεγχο» και «εκείνοι που διαχειρίζονται το σύστημα». Τον έλεγχο του συγκεκριμένου chatbot τον έχει η OpenAI. Αλλά το πρόσφατο πολύκροτο σίριαλ με την απομάκρυνση και επιστροφή του συνιδρυτή και διευθύνοντος συμβούλου Sam Altman μέσα σε λίγα 24ωρα, είχε ακριβώς να κάνει με τη διαδικασία ελέγχου του πόσο γρήγορα, προς ποια κατεύθυνση και με ποιες δικλείδες ασφαλείας αναπτύσσεται η τεχνητή νοημοσύνη.

O Altman ήθελε ταχεία βήματα και εξασφάλιζε τη χρηματοδότηση για αυτό και οι 4 διοικητές του ΔΣ φαίνεται να ήθελαν μία πιο ελεγχόμενη πορεία, φοβούμενη για τον αντίκτυπο. Μάλιστα ο ίδιος ο Altman πρόσφατα επιβεβαίωσε ουσιαστικά ότι βρίσκεται σε φάση εξέλιξης ένα πρόγραμμα υπερευφυούς τεχνητής νοημοσύνης με την κωδική ονομασία Q*, χωρίς να αποκαλύψει λεπτομέρειες για αυτό.

Σύμφωνα με το Reuters το πρόγραμμα είχε αρχίσει να δείχνει εκπληκτικές ικανότητες κυρίως στον μαθηματικό τομέα και έδειχνε ότι θα μπορούσε σύντομα να γίνει το πιο προηγμένο πρόγραμμα generative AI με «απρόβλεπτες δυνατότητες».

Οι διαχρονικές προειδοποιήσεις

Τον περασμένο Μάρτιο 1.000 εμπειρογνωμόνες τεχνητής νοημοσύνης και στελέχη της βιομηχανίας ΑΙ, μεταξύ των οποίων και ο Έλον Μασκ, ζητούσαν εξάμηνη παύση στην ανάπτυξη όλων των συστημάτων που είναι ισχυρότερα από το GPT-4 της OpenAI, σε μια ανοιχτή επιστολή, στην οποία επικαλούνταν πιθανούς κινδύνους για την κοινωνία και την ανθρωπότητα.

Μέσω της επιστολής, η οποία εκδόθηκε από το μη κερδοσκοπικό Ινστιτούτο «Future of Life Institute» τόνιζαν ότι η παύση είναι αναγκαία προκειμένου να υπάρξουν συστήματα ελέγχου της ανάπτυξης της ΑΙ και εξηγούσαν τους κινδύνους, που ελλοχεύουν, με τον πιο απλό να είναι η πιθανή κατάχρηση των συστημάτων σε απόπειρες phishing, παραπληροφόρησης και εγκλημάτων στον κυβερνοχώρο.

Οι φόβοι για το πού μπορούν να φτάσουν οι μηχανές βεβαίως δεν είναι νέοι. Ακόμη και πριν από την έκρηξη της generative AI, τον Ιούλιο του 2015, οι Στίβεν Χόκινγκ, Έλον Μασκ και Στιβ Βόζνιακ, είχαν ενώσει τις φωνές τους με εκατοντάδες ακόμη επιστήμονες σε μία επιστολή προς τη Διεθνή Κοινή Διάσκεψη για την Τεχνητή Νοημοσύνη στο Μπουένος Άιρες, στην οποία προειδοποιούν ότι τα προγράμματα ΑΙ είναι δυνητικά πιο επικίνδυνα για την ανθρωπότητα από τα πυρηνικά όπλα.

Ο αντίκτυπος στην αγορά εργασίας

Ακόμη και εάν η τεχνητή νοημοσύνη δεν πέσει στα χέρια αυταρχικών καθεστώτων ή πολεμοχαρών ηγετών, αναμφίβολα θα φέρει δραστικές αλλαγές στην αγορά εργασίας.

Μελέτη που είχαν υπογράψει ερευνητές της OpenAI υπολόγιζε οτι το 80% των εργαζομένων των ΗΠΑ θα δει τουλάχιστον το 10% των εργασιακών καθηκόντων του να επηρεάζονται από τα μεγάλα πολυγλωσσικά μοντέλα (LLMs) και το 19% των εργαζομένων ίσως δει το 50% των καθηκόντων του να επηρεάζεται.

Σύμφωνα με τη μελέτη, ο μακροπρόθεσμος κίνδυνος είναι η απώλεια ελέγχου. Ορισμένοι φοβούνται ότι η ΑΙ «θα μπορούσε να ξεφύγει εκτός του ελέγχου μας ή ακόμη και να καταστρέψει την ανθρωπότητα» προειδοποιούσε η μελέτη, που υπογράμμιζε την ανάγκη να υπάρχουν δικλείδες ασφαλείας, να μπορεί δηλαδή κάποιος να τραβήξει – έστω προσωρινά – την πρίζα, αν χρειαστεί.

Ποιος έχει τον έλεγχο

Προς το παρόν δεν υπάρχει σχετικό ρυθμιστικό ή εποπτικό πλαίσιο σε κρατικό πόσο μάλλον διεθνές επίπεδο.

Οι ίδιες οι εταιρείες ανάπτυξης εργαλείων τεχνητής νοημοσύνης καλούνται να ορίσουν τις επιστημονικές ομάδες εκείνες που παρακολουθούν τις εξελίξεις, διαβλέπουν τους κινδύνους και χτυπάνε καμπανάκια.

Εκείνοι που θα μπορούν και να τραβήξουν εγκαίρως την πρίζα αν το εφιαλτικό σενάριο κινδυνέψει να γίνει πραγματικότητα, θα έχουν μία τεράστια δύναμη στα χέρια τους.

Νατάσα Στασινού • [email protected]